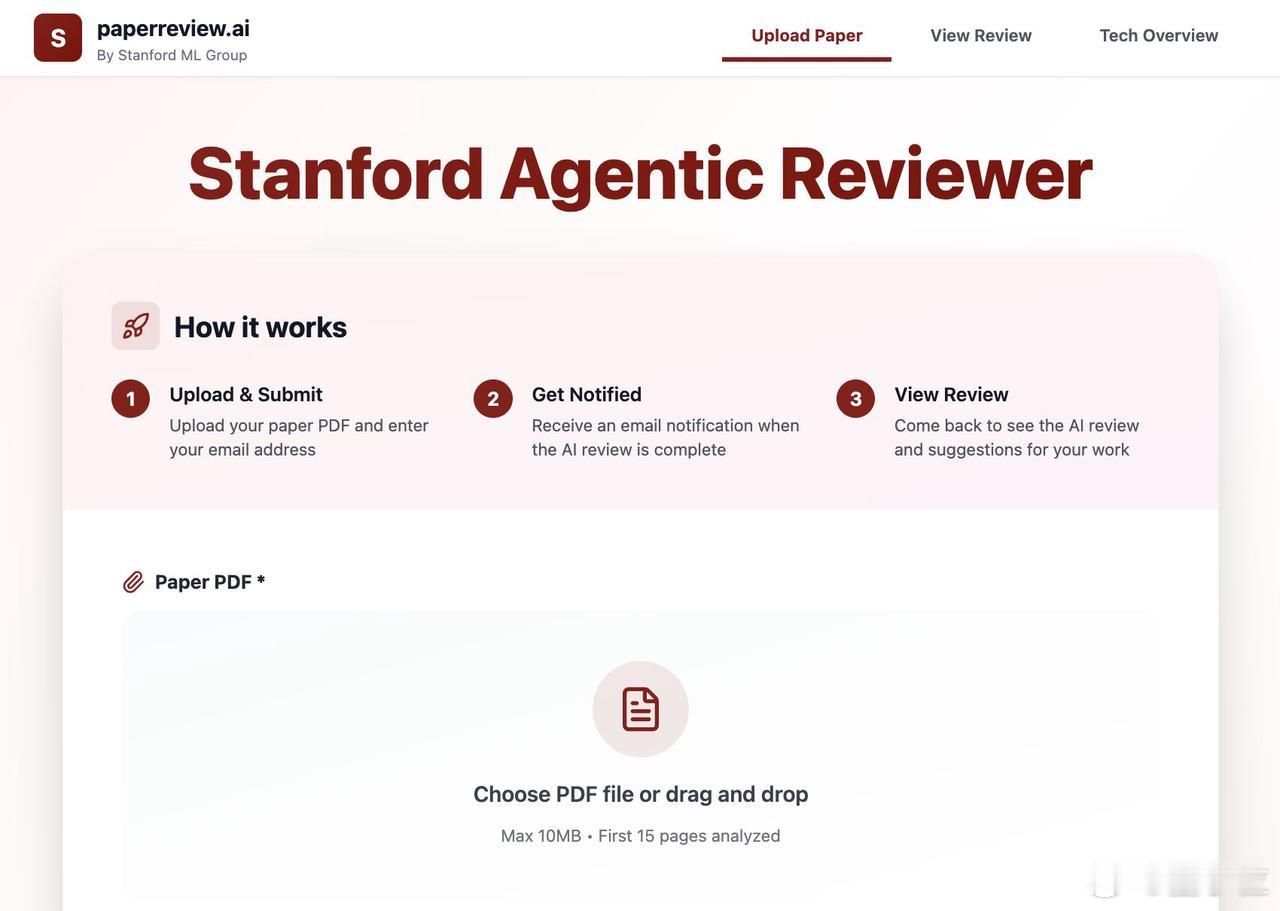

吴恩达团队发布了开源项目Agentic Reviewer,专门用来自动评审论文。起因是,吴恩达手下一个学生,3年内投稿6次全被拒,每次光等审稿反馈就要半年。于是团队索性做了这个工具,希望研究者能快速拿到高质量反馈,加速迭代。评论区有人表示:不用等6个月被人类拒稿了,现在AI在几分钟内就能拒绝你,早拒早改早提交。这个工具解决了科研中的痛点:传统评审不仅周期长,而且收到的评论大都聚焦在"不值得发表",很少给出具体修改建议。项目的工作流程是这样:提交论文后选择投稿的期刊或会议,系统会根据那个会议的评审风格来判断。它会把PDF转成Markdown,提炼关键词,然后用搜索工具去arXiv上找最新相关研究,挑出最相关的论文进行总结,最后结合原文和这些总结,按模板给出完整的评审意见和具体可操作的修改建议。团队还训练它模仿ICLR 2025的评审给论文打1到10分。具体是先从原创性、研究问题重要性、结论是否有依据等7个维度打分,再算出最终分数。测试数据显示:用ICLR 2025的真实评审数据做Spearman相关性测试,AI审稿人vs人类审稿人的相关性是0.42,而人类审稿人vs人类审稿人才0.41。也就是说,AI的评审逻辑和人类审稿人的一致性非常高,甚至在数值上略微胜出。需要注意的是,AI审稿主要参考arXiv上的内容,所以目前最适合AI、计算机科学等相关领域,这些领域的最新研究和相关工作都在arXiv上公开可查。感兴趣的科研人可以体验一波:paperreview.ai/