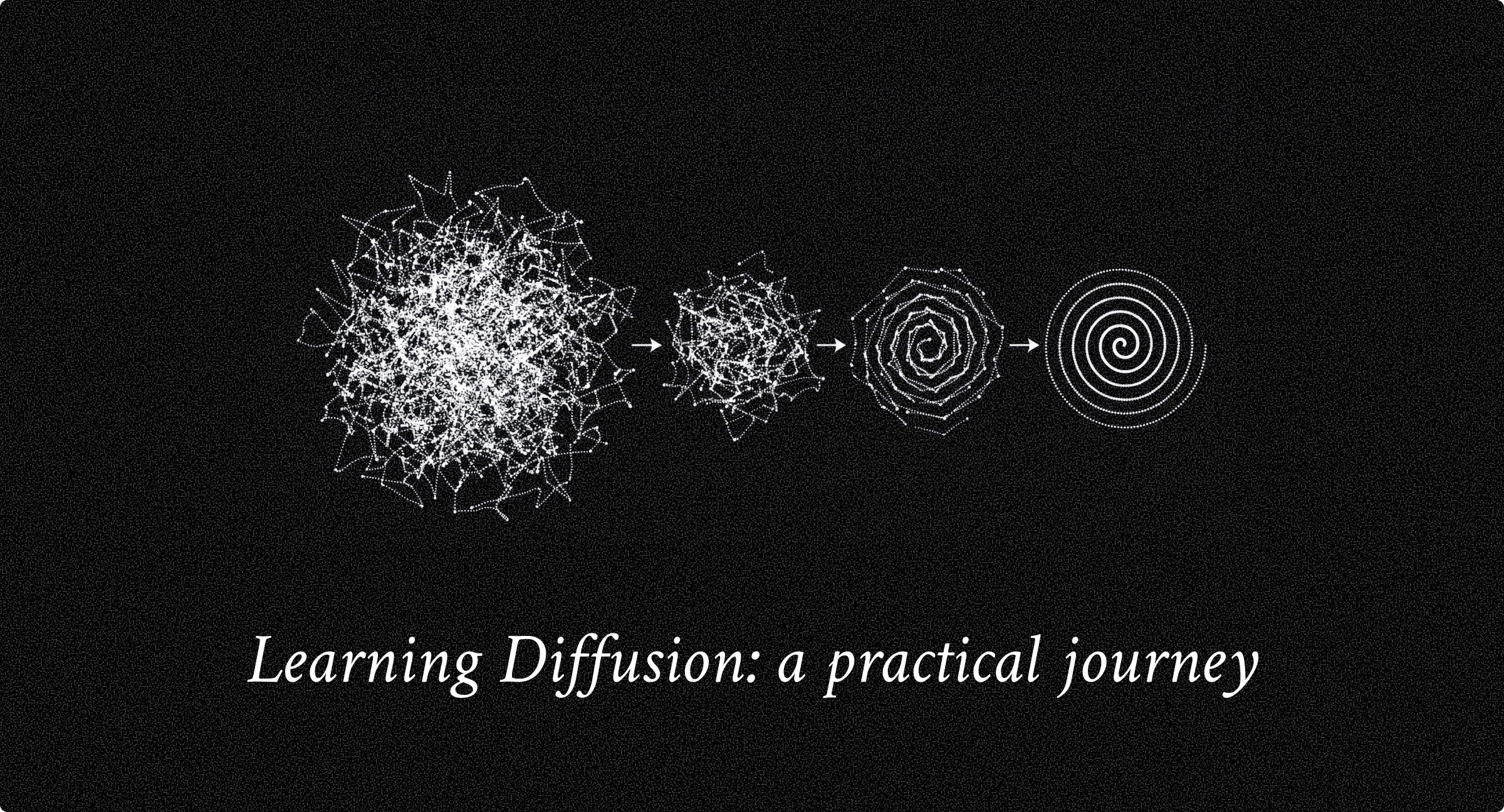

learning-diffusion 是一个从零开始实现并学习扩散模型(Diffusion Models)的实战指南项目。github.com/ludocomito/learning-diffusion该项目通过一系列循序渐进的 Jupyter Notebook 教程,帮助开发者和学习者深入理解扩散模型的原理与实现细节。该项目主要包含以下 5 个核心部分,每个部分对应一个 Notebook,难度逐步进阶:1️⃣Diffusion Basics (扩散模型基础) 内容:使用简单的 2D 螺旋数据集(Spiral Dataset)来演示扩散模型的基本概念。 目的:让初学者在处理复杂的图像数据之前,通过可视化 2D 数据点的分布,直观理解“前向加噪”和“反向去噪”的过程。2️⃣Generating Images (图像生成) 内容:将扩散模型应用到真实的图像数据上(使用 MNIST 手写数字数据集)。 技术点:实现了用于图像去噪的 U-Net 架构,并展示了如何从纯噪声中生成看起来真实的数字图像。3️⃣Classifier-Free Guidance (无分类器引导) 内容:探讨如何控制生成的图像内容(例如,指定生成数字 "5" 而不是随机生成)。 技术点:通过训练一个既能进行有条件生成又能进行无条件生成的模型,在推理阶段通过引导(Guidance)增强模型对条件的依从性,这是现代生成模型(如 DALL-E 2, Stable Diffusion)提高生成质量的关键技术。4️⃣Flow Matching (流匹配) 内容:介绍了一种传统扩散模型的替代方案——基于连续归一化流(Continuous Normalizing Flows)。 特点:学习的是速度场(Velocity Fields)而不是噪声预测,能够定义从噪声到数据的平滑、确定性轨迹。这通常能带来更快的采样速度和更稳定的训练。5️⃣Latent Diffusion (潜在扩散模型) 内容:探索如何在压缩的**潜在空间(Latent Space)**中进行扩散,而不是在原始像素空间。 意义:结合了变分自编码器(VAE),这是 Stable Diffusion 等高性能模型背后的核心技术,能够大幅降低计算资源消耗并生成高分辨率图像。科技先锋官