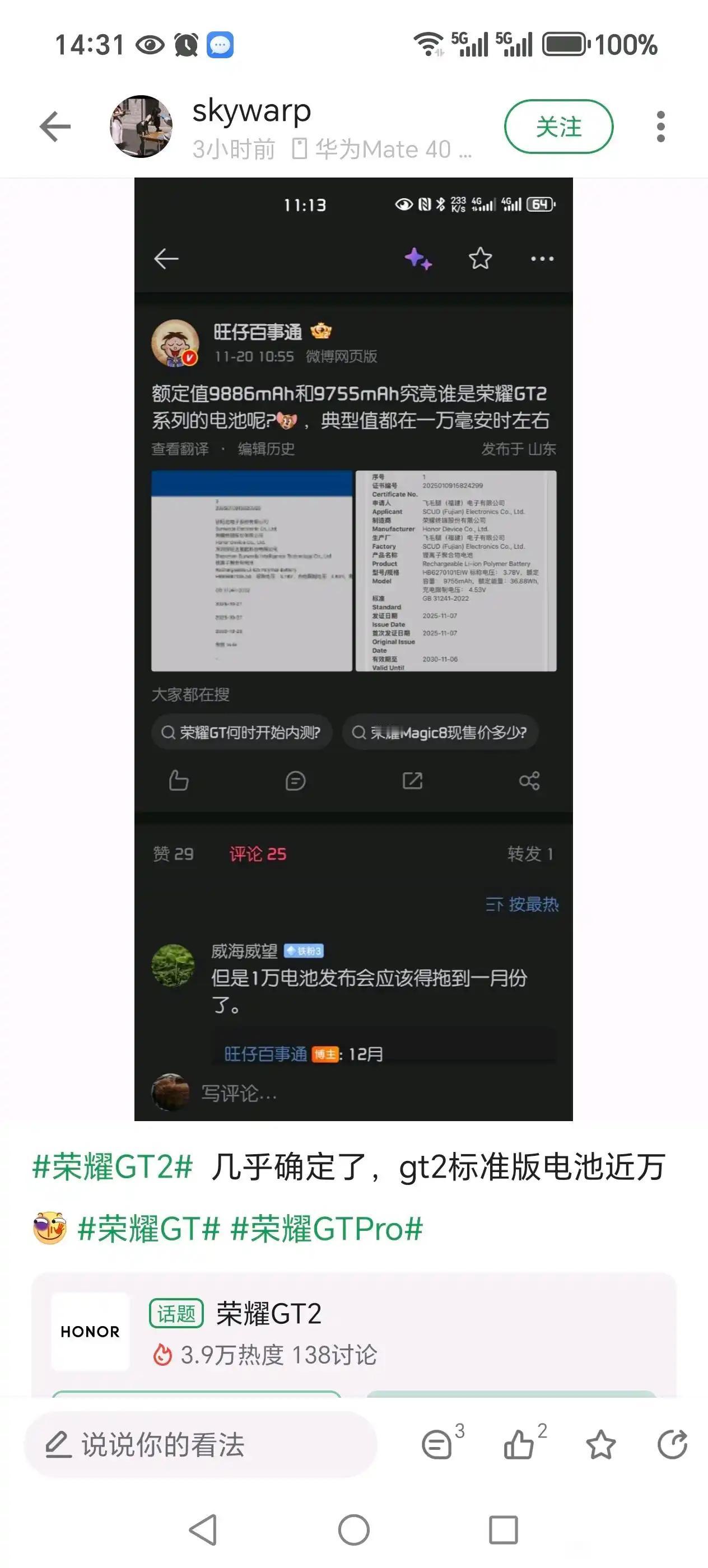

华为又填补一项空白,联合上海交大、西安交大、厦门大学发布AI容器技术——Flex:ai,并向外界开源,实现AI平民化。 要知道现在AI行业最大的痛点就是算力浪费——很多小模型用一张整卡太浪费,大模型又不够用,行业平均算力利用率才30%-40%,相当于一半以上的算力都在“躺平”!英伟达的Run:ai能解决这问题,但只绑定自家GPU,还得花钱用;华为直接联手上海交大、西安交大、厦大,搞出了更全能的Flex:ai! 这技术简直是“算力盘活神器”:和上交合作的XPU池化框架,能把单张GPU/NPU切分成10%粒度的虚拟卡,一张卡能同时跑多个任务,利用率直接提升30%;和西交搞的智能调度器,能自动匹配任务和算力,负载再波动也不卡顿;还有厦大联手研发的跨节点技术,能把所有空闲算力聚合成“共享池”,普通服务器也能用上高端算力! 更牛的是,Flex:ai不挑硬件,英伟达GPU、华为昇腾NPU都能用,不像Run:ai只能绑死英伟达生态。而且已经在瑞金医院落地了,103万张病理切片的癌症识别模型,靠它用16张卡就完成了训练,直接把算力可用度从40%冲到70%,这效率谁看了不佩服! 最让人惊喜的是华为直接开源,所有核心技术都免费开放给开发者。以前AI是大企业的“专属游戏”,小企业和科研机构根本玩不起,现在华为这波操作,直接降低了AI门槛,真要实现“AI平民化”了!这才是真正的技术普惠,比花大价钱买技术的英伟达格局大太多! 不得不说华为这“以软件补硬件”的路走对了,不靠垄断靠创新,还愿意共享成果。现在AI容器是大势所趋,预计2027年75%的AI任务都要用这技术,华为这波直接抢占了行业标准话语权!