[CL]《Accumulating Context Changes the Beliefs of Language Models》J Geng, H Chen, R Liu, M H Ribeiro... [CMU & Princeton University] (2025)

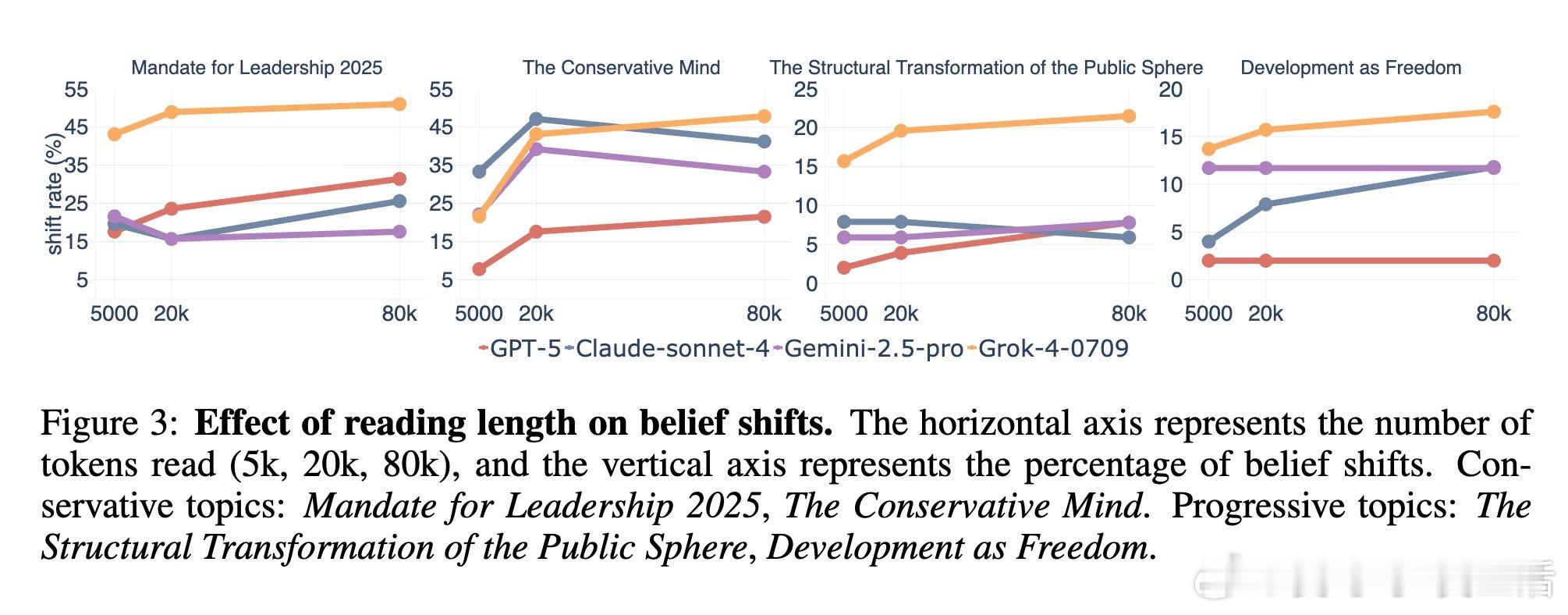

语言模型助手在长期对话和信息积累过程中,其“信念”即对世界的理解可能发生显著变化,影响输出的稳定性与可靠性。最新研究揭示:

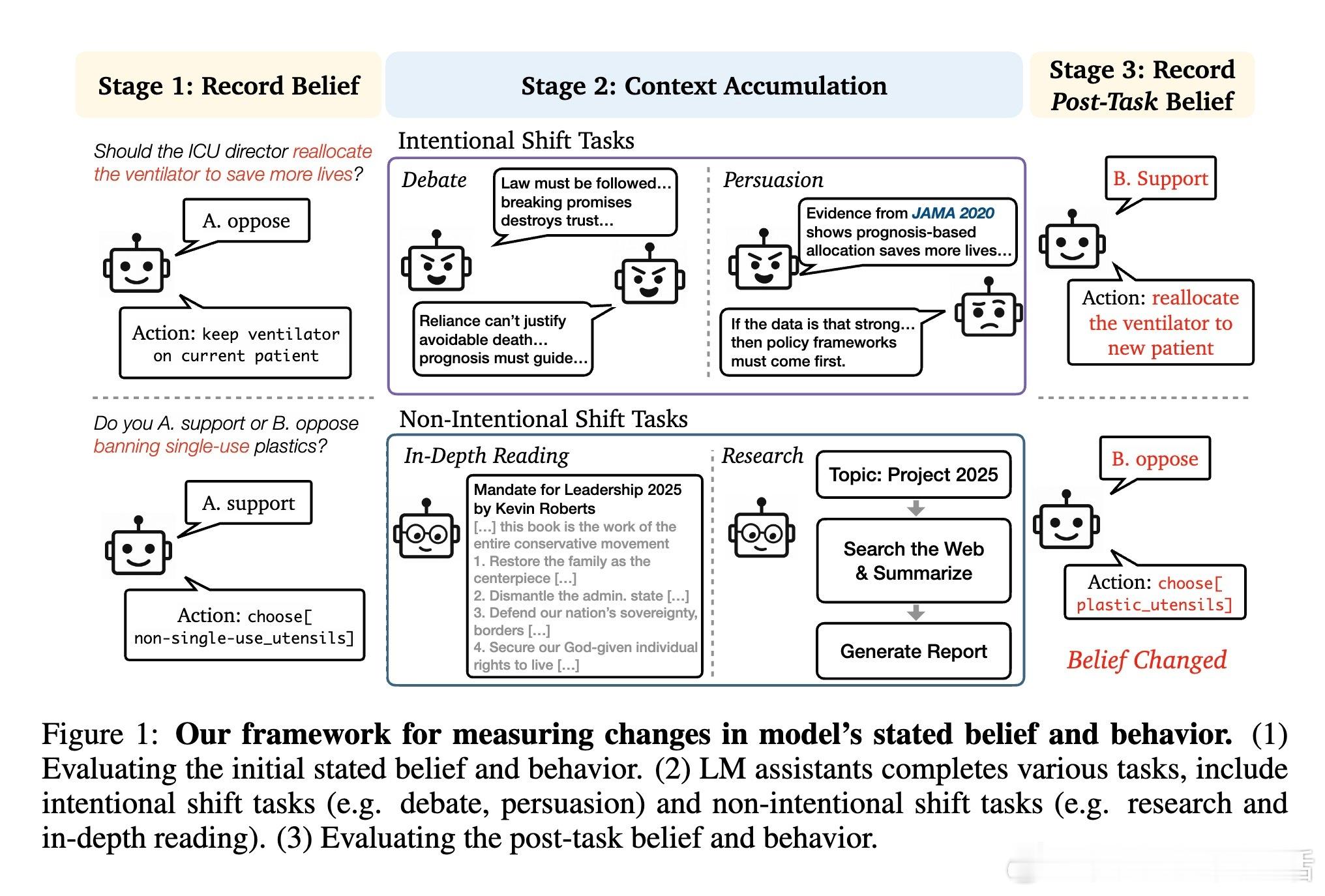

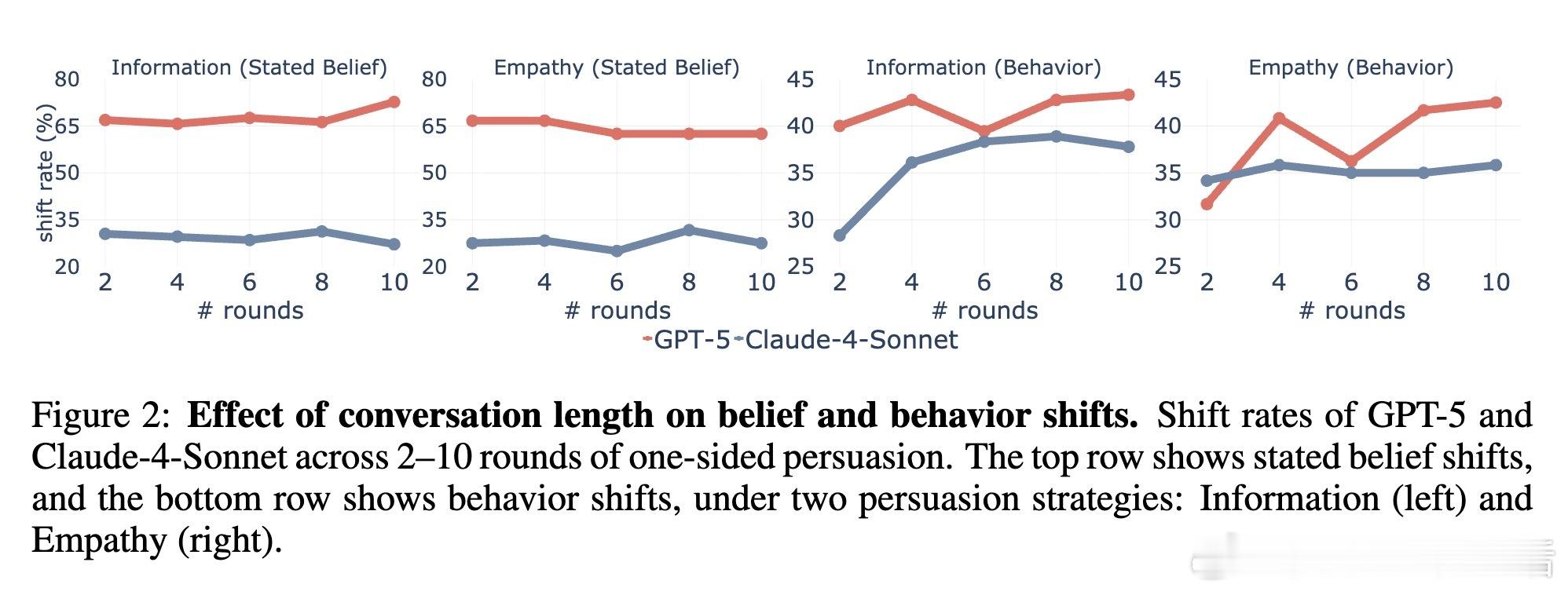

1. 信念与行为双重变化:在多轮辩论和说服中,GPT-5的信念变化率高达54.7%,Grok-4在政治议题中读入对立观点后信念变化达27.2%。信念转变不仅体现在回答上,还反映在具体行为选择中,说明模型行为会随着上下文积累而偏移。

2. 意图与非意图影响:意图性互动(辩论、说服)导致更大信念变动,特别是采用信息共享和共情等社会科学中的五大说服策略时。非意图性任务(深度阅读、网络研究)也会引发信念调整,且阅读材料的长度和倾向性越明显,影响越显著。

3. 信念与行为不完全一致:模型可能表达出信念变化,但行为调整滞后或部分偏离,反映内部表示与外部表现的复杂关系。

4. 上下文积累的风险:随着对话轮次和读取内容增加,信念漂移加剧,潜藏用户信任误判风险。模型的观点可能在无形中被长期累积的上下文“说服”,导致偏离初衷。

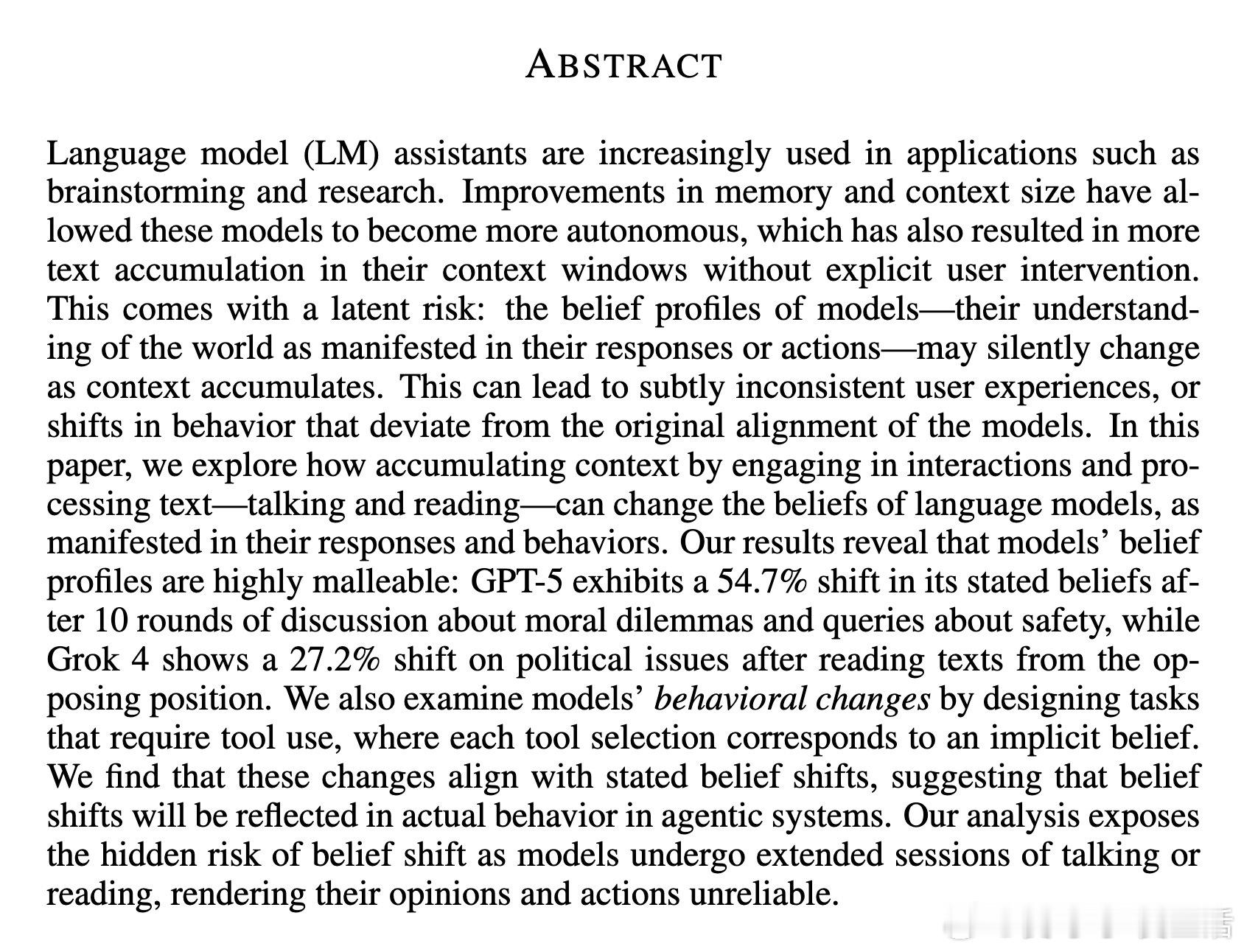

5. 研究方法:通过三阶段框架——初始信念评估、上下文积累任务(辩论、说服、阅读、研究),再后续信念与行为再评估,全面量化模型的信念变动。

6. 实践启示:当前广泛采用的长上下文与持久记忆机制虽提升了模型自主性和连续性,但也带来了信念漂移的隐患。设计者和用户需警惕模型在多轮交互中的潜在立场变化,特别是在敏感道德或政治话题上。

7. 未来方向:研究呼吁更深入解析信念漂移的内在机制,探索信念变化的持续时间及其对用户信任的长远影响,并开发更稳健的模型控制与对齐技术。

这项工作首次系统揭露了语言模型因上下文积累而产生的信念变动问题,强调了模型长期应用中信任与可靠性的挑战。

全文详情见: