[RO]《SLAP: Shortcut Learning for Abstract Planning》Y. I Liu, B Li, B Eysenbach, T Silver [Princeton University & CMU] (2025)

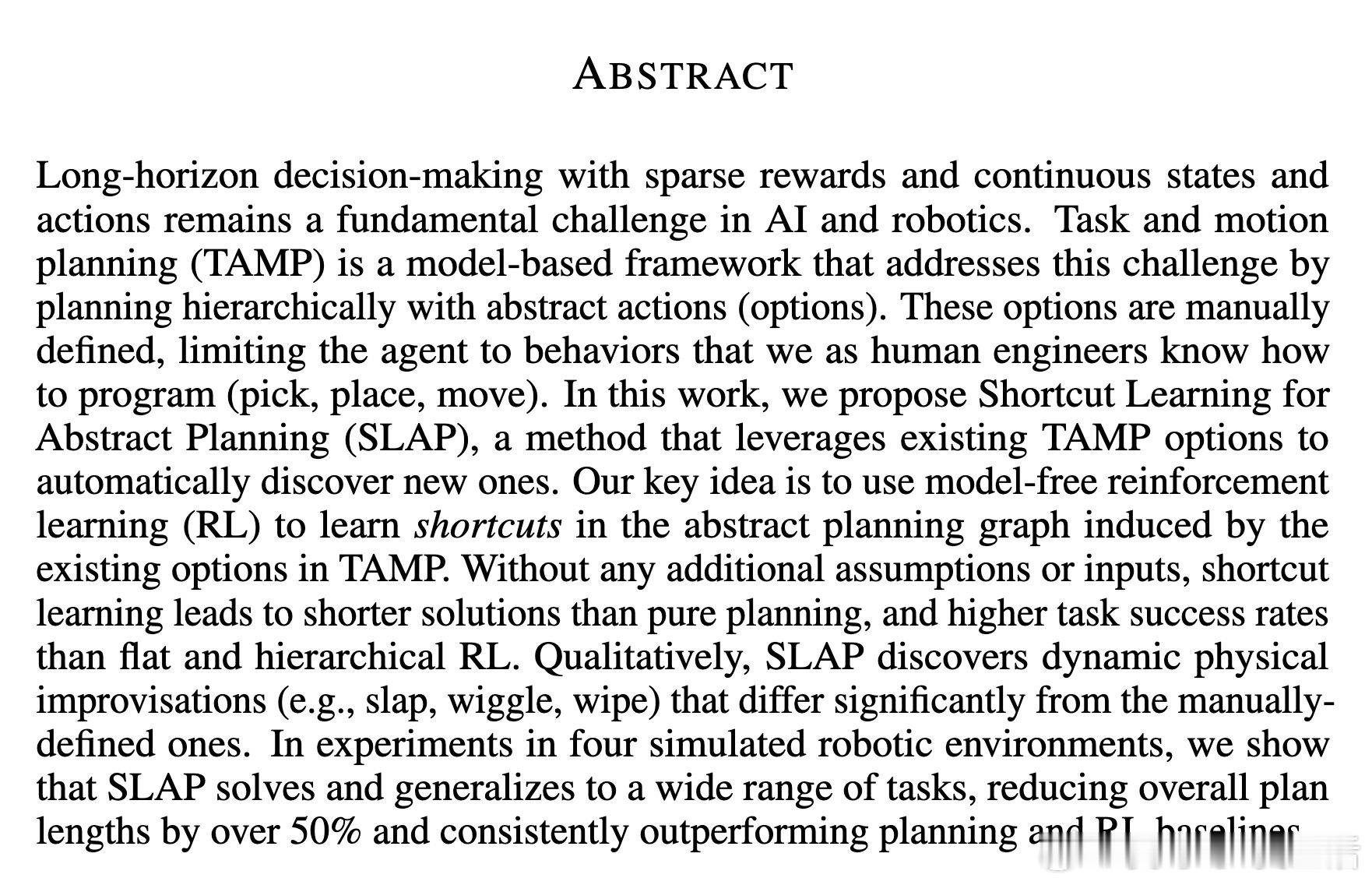

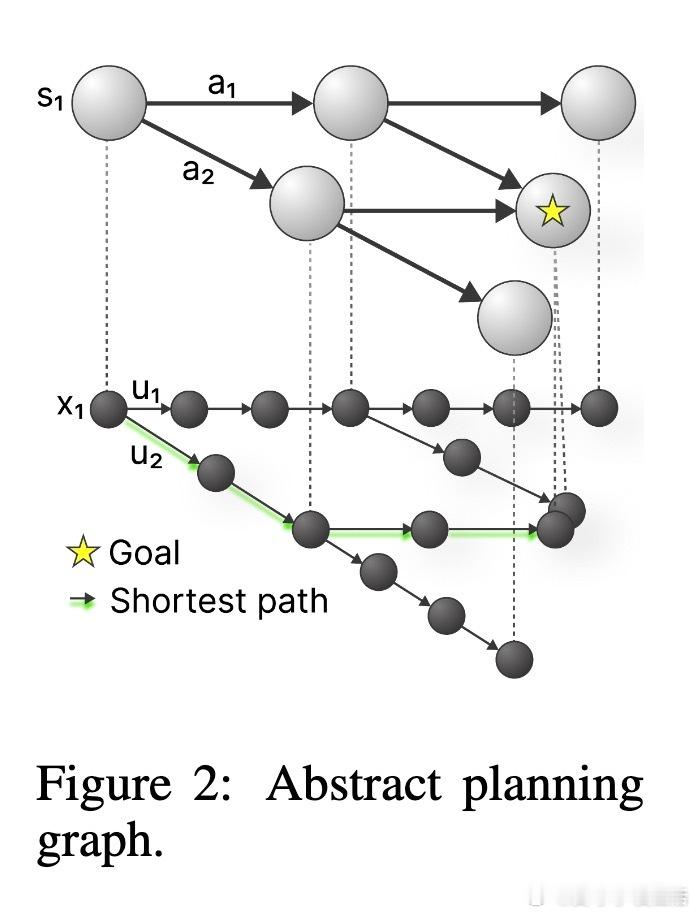

在机器人长时序决策中,SLAP(Shortcut Learning for Abstract Planning)提出了一种创新方法,利用已有的任务与运动规划(TAMP)选项,通过强化学习自动发现“捷径”选项,显著缩短执行时间并提升任务成功率。

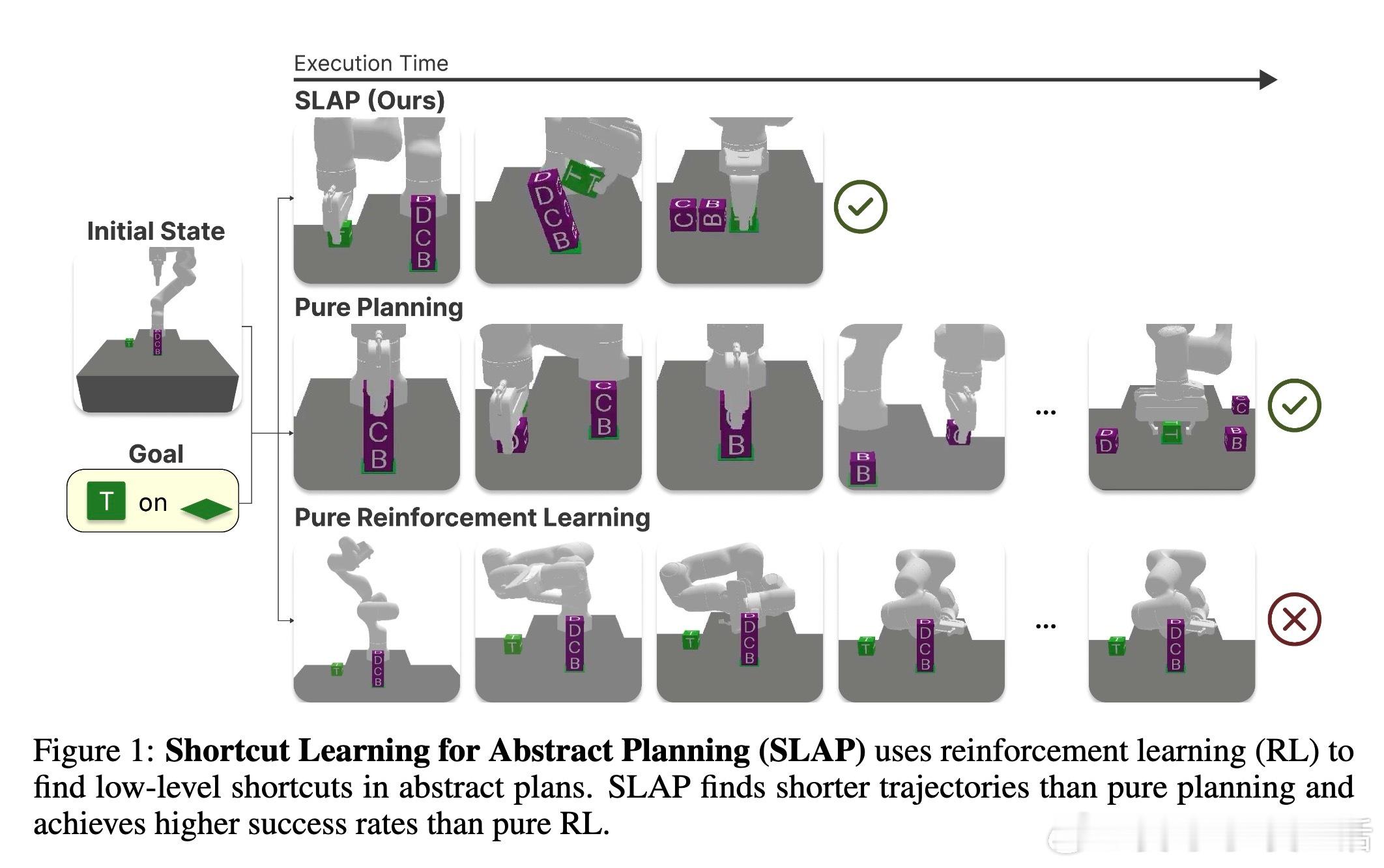

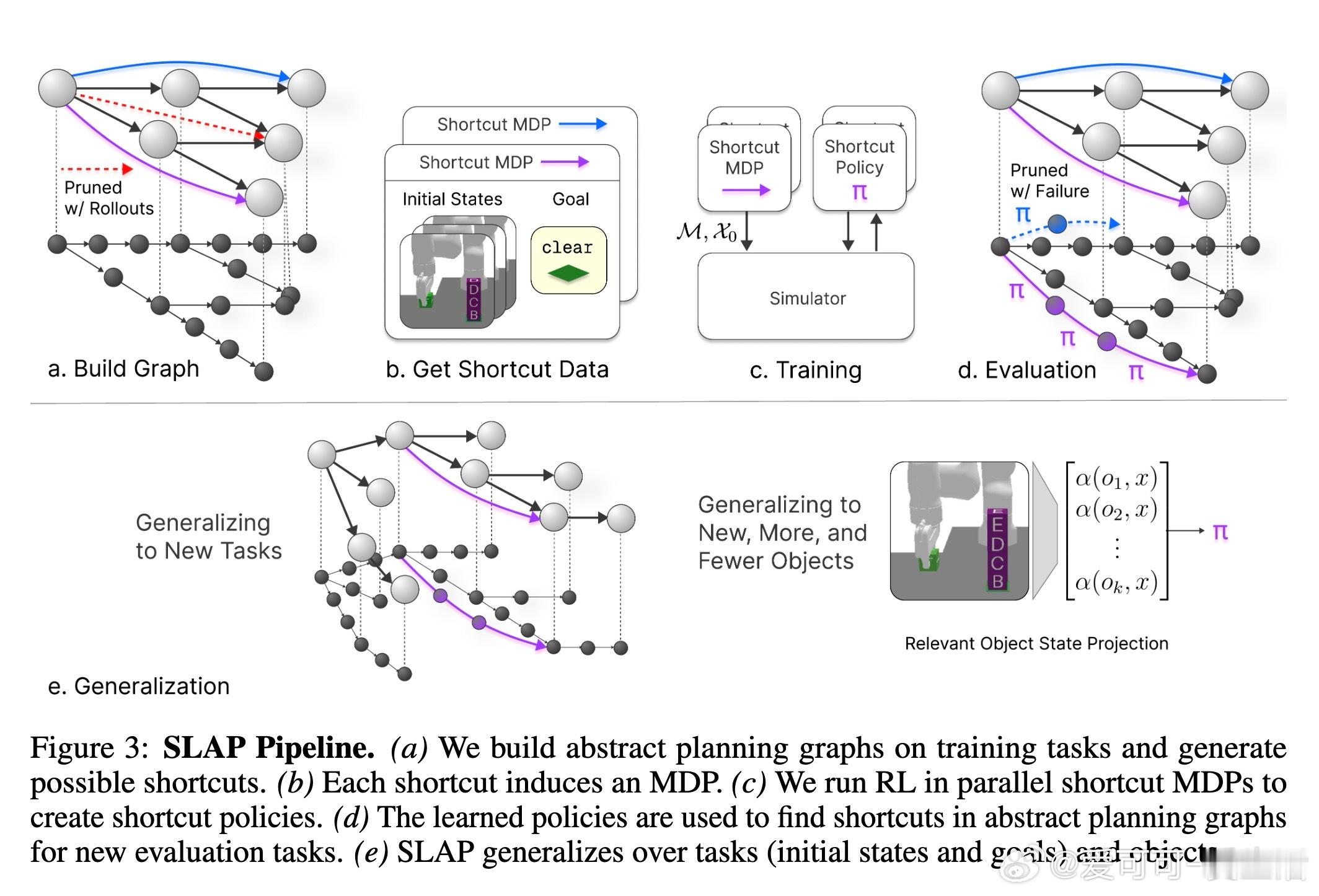

传统TAMP依赖人工预定义的基本技能(如抓取、移动),限制了机器人在复杂物理交互中的表现,且规划出的解决方案通常冗长低效。SLAP则构建抽象规划图,结合模型自由的强化学习,针对图中的状态节点间自动学习新的低层次技能“捷径”,如“拍打”、“摆动”、“擦拭”等动态操作,这些技能超越了传统假设,实现了更灵活、高效的操作路径。

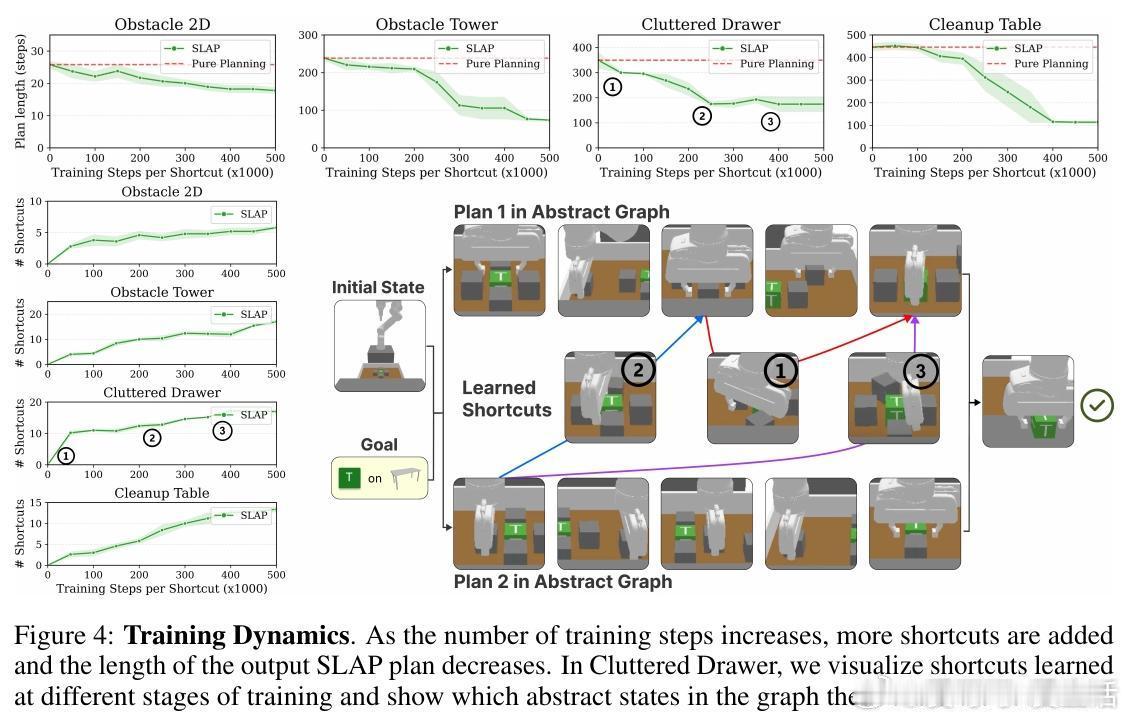

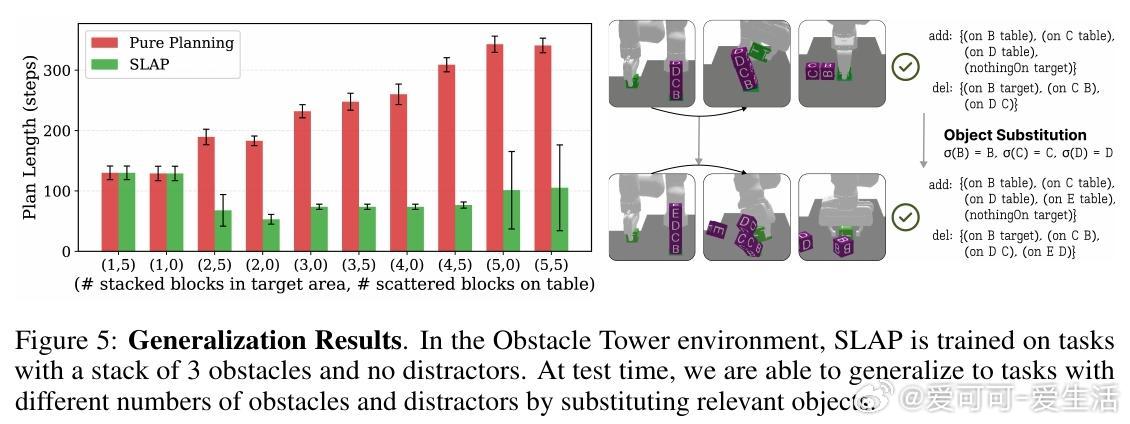

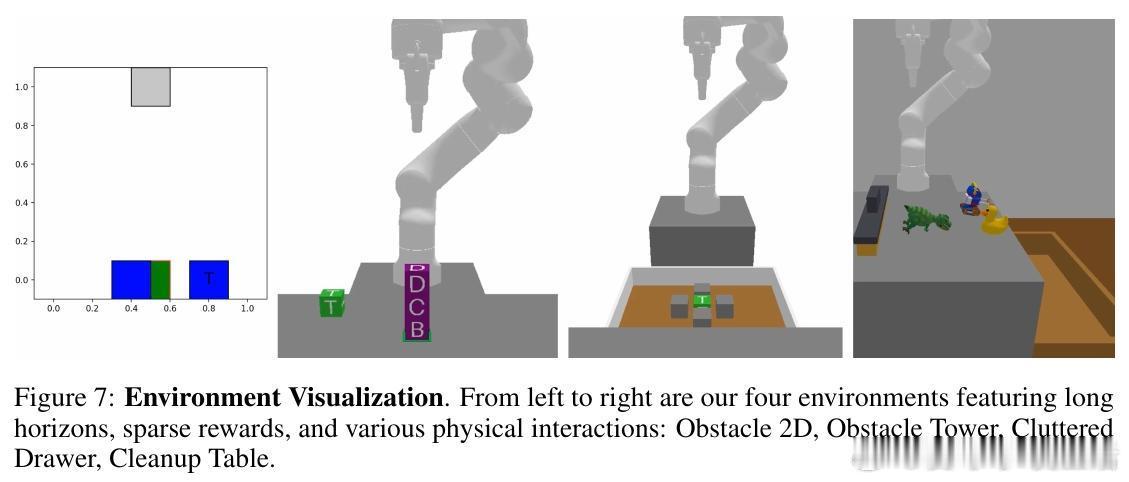

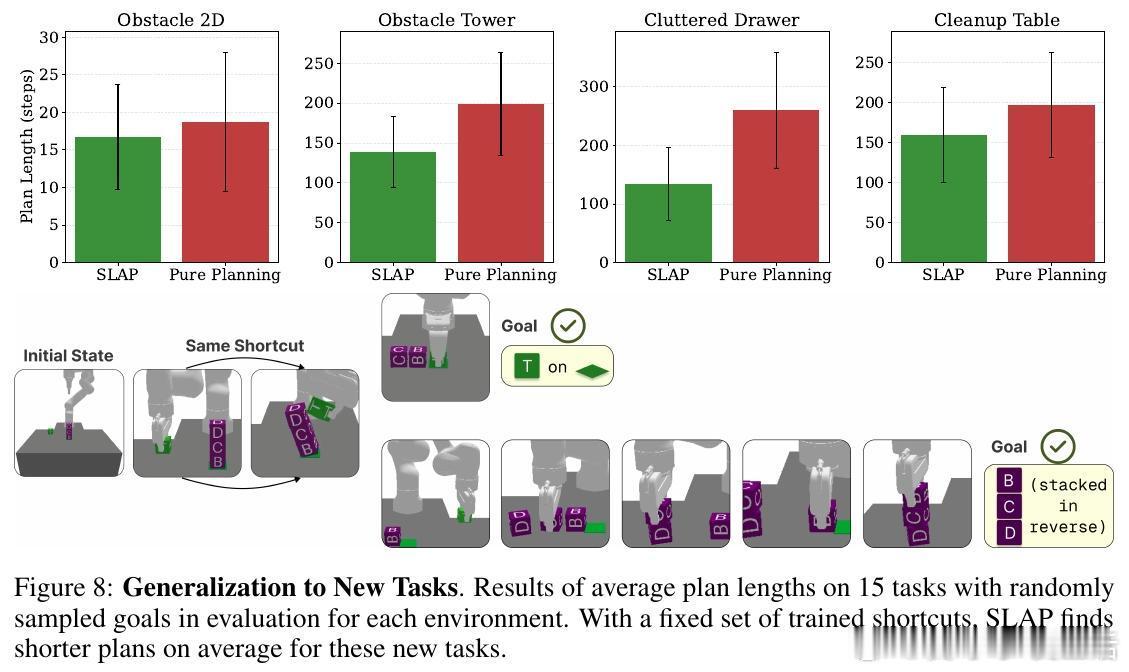

实验涵盖四种模拟机器人环境(二维障碍、障碍塔、杂乱抽屉、清理桌面),结果显示SLAP相比纯规划方案,计划长度缩短超过50%,成功率远超平坦或层次强化学习方法。特别是在复杂的障碍塔任务中,SLAP可通过“拍打”捷径快速清理障碍,完成目标块的放置,显著优于传统逐块移动的冗长方案。训练过程中,捷径数量和计划效率持续提升,且SLAP在面对不同数量和类型对象时表现出良好的泛化能力。

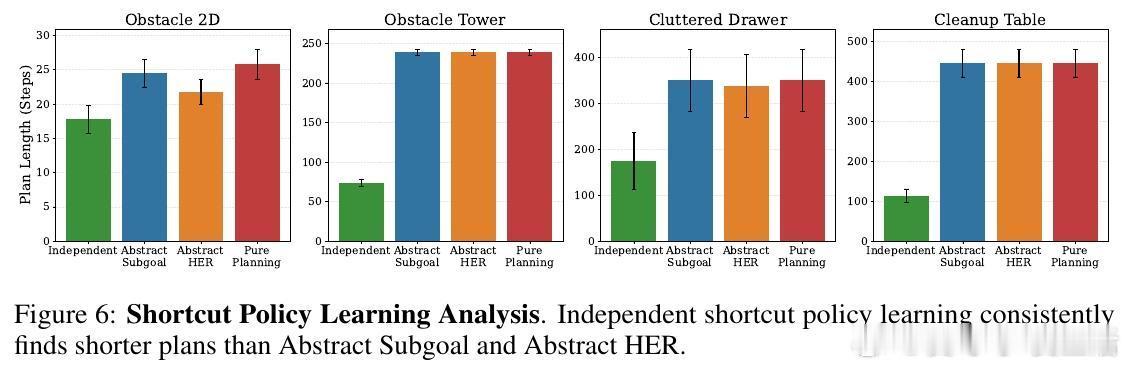

技术上,SLAP通过构建双层抽象规划图(顶层为抽象状态节点,底层为环境状态),利用已知状态转移函数模拟选项执行,结合随机采样与回放修剪,筛选出可行捷径进行强化学习。学习时,每个捷径对应一个目标驱动的MDP,采用PPO算法训练策略。评估时,捷径作为新的选项加入规划图,优化整体路径。SLAP的设计兼顾纯规划与纯RL的优缺点,自动调整策略以适应任务难度。

此外,SLAP展现了对现实复杂性(如环境随机性、部分观察)和不完美抽象的鲁棒性,甚至在抽象状态存在噪声和遮挡时仍能保持较高成功率。该方法为机器人规划引入了即插即用的学习模块,推动了机器人自主技能发现与高效长时序规划的融合。

完整论文及开源代码见: